贝叶斯角度看 L1 & L2 正则化

从贝叶斯的角度来看,正则化等价于对模型参数引入先验分布。其中,

- L1正则化对应于拉普拉斯分布,

- L2正则化对应于高斯分布。

频率学派 VS 贝叶斯学派

频率学派(Frequentists)与贝叶斯学派(Bayesians)都基于样本数据做分析。

其不同点主要在于对于 $X\sim F(x;\theta)$,概率学派将样本看作随机变量,而将 $\theta$ 看作常数,而贝叶斯学派将样本和 $\theta$ 均看作随机变量。

概率学派的着眼点在样本空间,基本依托于大数定律和中心极限定理,其贵在于得到越多越好的样本,然后计算其频率来逼近该事件的真实概率。

而贝叶斯学派的着眼点在参数空间,更加重视参数 $\theta$ 的分布,表现在对事件有一定的先验知识了解,然后再用似然度去修正之前的知识了解,如果当前的观测值越符合我们的先验知识,那么似然度就越大,得到的后验概率也就越大,反之亦然。

贝叶斯概率论假设观察者对某事件处于某个知识状态中(例如:有一个袋子里面装了红球和黑球,已知这个袋子里面是5黑5红的概率是0.8,是10黑5红的概率是0.2),之后观察者开始新的观测或实验(有放回抽取100次,得到80次黑的,20次红的)。经过中间的独立重复试验,观察者获得了一些新的观测结果,这些新的观测将以含有不确定性的逻辑推断的方式影响观察者原有的信念(即观测者一开始认为袋子里是5黑5红的可能性更大,但是经过了上面的事实之后,修正了原有的信念,认为是10黑5红可能性更大)。

上面的例子用贝叶斯概率论的语言来描述,就是观察者持有某个前置信念(prior belief),通过观测获得统计证据(evidence),通过满足一定条件的逻辑一致推断得出的关于该陈述的「合理性」,从而得出后置信念(posterior belief)来最好的表征观测后的知识状态(state of knowledge)。

看似贝叶斯框架比较的完美,而且可以克服一些频率派困难(比如投骰子次数不多,那么计算的频率显然与真实的分布想去甚远,但是贝叶斯的先验知识可以缓和这种极端情况)。但是贝叶斯的先验知识没有具体、规则化的获得方法,每个人的先验知识都可能是不一样的,而不良的先验概率甚至会使得最终的估计偏离真实的值。对此,贝叶斯的先验知识最好是客观计算出来的,抑或者拿不准时候用弱信息甚至无信息的先验假设来尽可能避免这类问题。

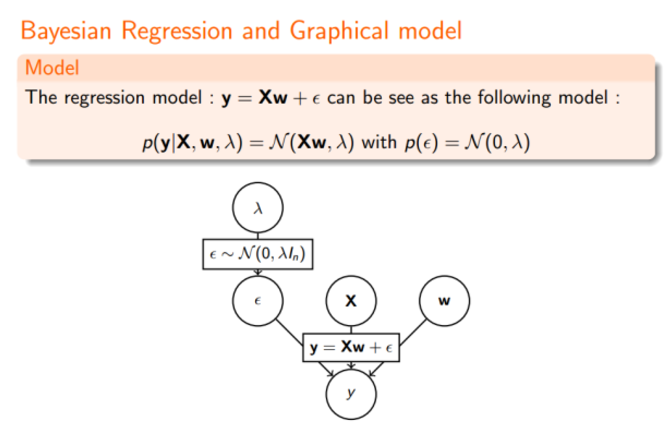

Linear Regression

最原始的 Linear Regression 模型如下

这就导出了我们原始的 least-squares 损失函数,但这是在我们对参数 w 没有加入任何先验分布的情况下。在数据维度很高的情况下,我们的模型参数很多,模型复杂度高,容易发生过拟合。比如我们常说的 “small n, large p problem”。(我们一般用 n 表示数据点的个数,用 p 表示变量的个数 ,即数据维度。当 的时候,不做任何其他假设或者限制的话,学习问题基本上是没法进行的。因为如果用上所有变量的话, p 越大,通常会导致模型越复杂,但是反过来 n 又很小,于是就会出现很严重的 overfitting 问题。

这个时候,我们可以对参数 w 引入先验分布,降低模型复杂度。

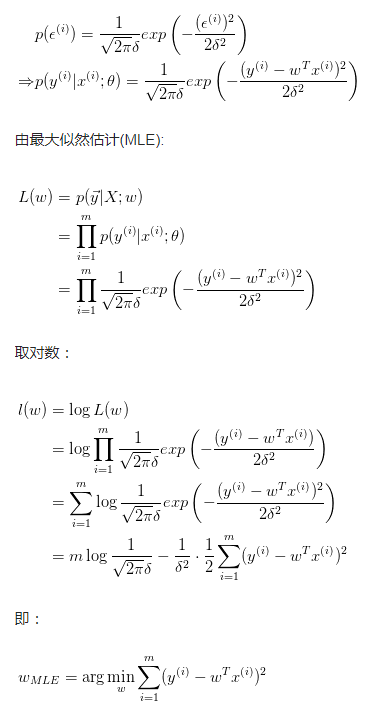

Ridge Regression

我们对参数 $w$ 引入协方差为 $\alpha$ 的零均值高斯先验。

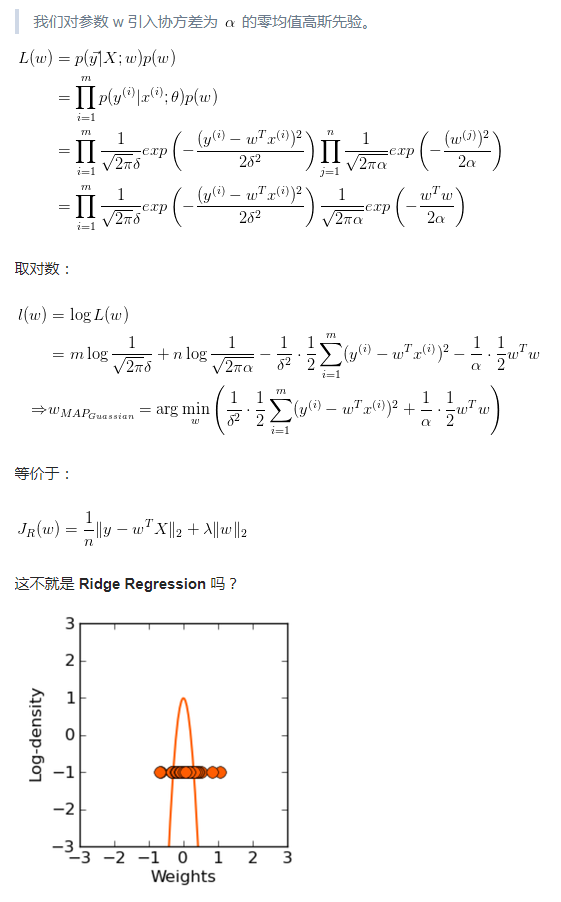

看我们得到的参数,在零附近是不是很密集,老实说 ridge regression 并不具有产生稀疏解的能力,也就是说参数并不会真出现很多零。假设我们的预测结果与两个特征相关,L2正则倾向于综合两者的影响,给影响大的特征赋予高的权重;而L1正则倾向于选择影响较大的参数,而舍弃掉影响较小的那个。实际应用中 L2正则表现往往会优于 L1正则,但 L1正则会大大降低我们的计算量。

Typically ridge or $l2$ penalties are much better for minimizing prediction error rather than ℓ1 penalties. The reason for this is that when two predictors are highly correlated, ℓ1 regularizer will simply pick one of the two predictors. In contrast, the ℓ2 regularizer will keep both of them and jointly shrink the corresponding coefficients a little bit. Thus, while the ℓ1 penalty can certainly reduce overfitting, you may also experience a loss in predictive power.

那现在我们知道了,对参数引入 高斯先验 等价于L2正则化。

LASSO

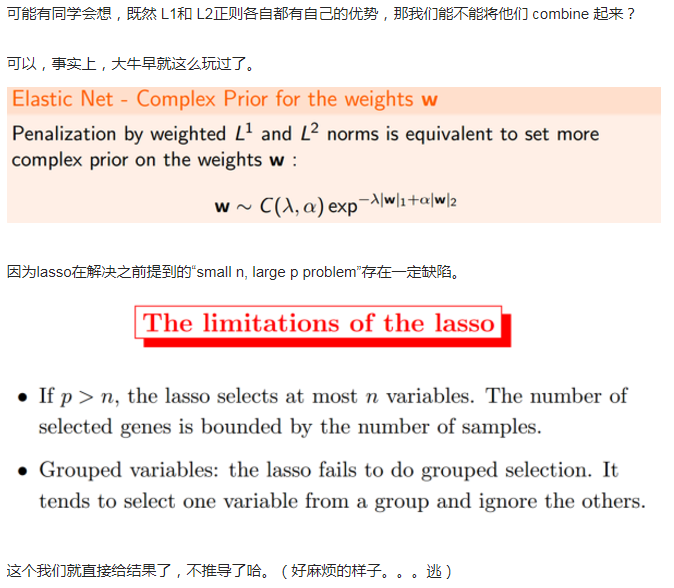

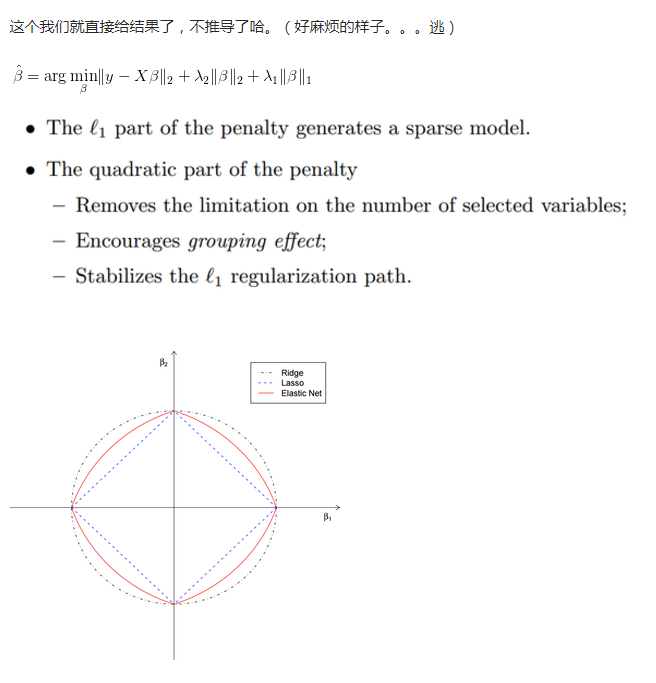

Elastic Net

总结

正则化参数等价于对参数引入 先验分布,使得 模型复杂度 变小(缩小解空间),对于噪声以及 outliers 的鲁棒性增强(泛化能力)。整个最优化问题从贝叶斯观点来看是一种贝叶斯最大后验估计,其中 正则化项 对应后验估计中的 先验信息,损失函数对应后验估计中的似然函数,两者的乘积即对应贝叶斯最大后验估计的形式。